リスニング:字幕ツール

前回は各種翻訳サービスの比較を行いました。今回はリスニング系のお話をしていこうと思います。リスニングを鍛えるには、ともかく多くのコンテンツを聞くことが重要なのは、おそらく誰しもが理解していると思います。分かっちゃいるが、それはがなかなか難しいので、皆困っているわけです(笑)。多く聞くには、自分にとって面白いコンテンツ、自分が好きなコンテンツでないと難しいと思いますし、長続きしません。私は映画が好きなので、映画が最もとっつきやすいコンテンツです。NetflixやAmazon Prime Videoなどのストリーミングサービスに入っているので、これを使わない手はありません。

もし、皆さん、Netflixに加入しているなら、Language Learning with Netflix(現在はLanguage Reactorという名前に変わっており、Netflixだけでなく、YouTubeなどにも対応しています)というChrome用拡張は超オススメです。もうこれは神アプリだと思ってます。

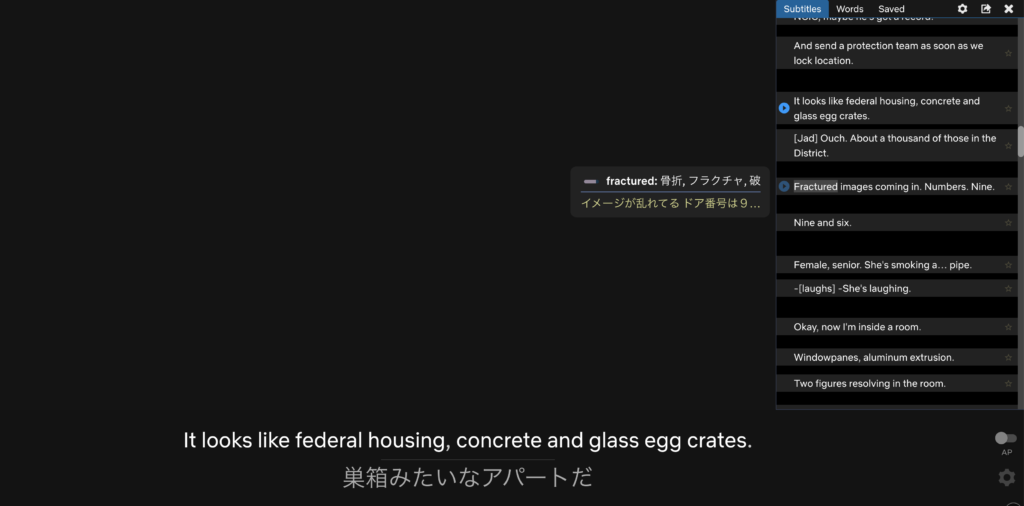

この拡張を入れると日本語と英語の字幕が同時に表示されるようになります。通常、Netflixの字幕の言語は1つしか選べないのですが、この拡張を入れると日本語と英語の字幕を両方同時に出てくるようになります。また、キーボードの矢印キーを使って一文ごとに進めたり戻したりもできます。再生スピードも変更可能です。さらに、一文ずつ再生が自動的に止まる「オートポーズ・モード」もあります。画面右側に表示されている文にマウスをかざすとその文の翻訳が出たり、一文一文を個別に再生したりすることもできます。

下のスクリーショットはLanguage Reactorを入れた状態で、Netflixで「マイノリティー・レポート」の1シーンを見ているところです。Netflixは映像のスクリーンキャプチャが取れないようになっているので映像の部分は黒塗りになってしまっていますが、画面下に元々のNetflixの字幕(英語)とLanguage Reactorが出している日本語の字幕が同時に表示されていること、画面右側に前後の字幕が表示されており、そこにマウスをかざすとその文の意味、選択されている語の意味が表示されていることが分かると思います。映画を見ていて何かわからない単語が出てきた時に、辞書を引かずに、マウスをかざすだけで意味を調べられるのはかなり重宝します。余談ですが、このセリフだけでマイノリティ・レポートのどのシーンだか分かる人は相当にマイノリティ・レポート通ですが、分かる人はいますでしょうか?(ヒント:ちょっと未来のヒューマン・コンピュータ・インターフェースを感じられるシーンです)。

スクリーンショットからではなかなか素晴らしさを伝えることが難しいので、みなさん、是非このChrome拡張を入れてNetflixやYouTubeなどを見てみてください。超絶便利であることをすぐに実感していただけると思います。

このChrome拡張は無料で利用することができますが、有料プランもあって、有料プランに入ると単語とかフレーズの保存ができたりとか、機械翻訳を同時に表示することもできるようになります。なんのために機械翻訳を表示できるようになっているのか定かではありませんが、Netflixの字幕は結構意訳されてることが多いので、機械翻訳で直訳をすることで学習の役立つ場合があるのかもしれません。個人的には無料プランでも十分過ぎるくらい便利だと思います。私は無料プランで使っています。

リスニング:書き起こし

もう一つ、リスニングを鍛える方法としてよく言われるのが「書き起こし(ディクテーション)」です。これも確かに有効な方法だと思いますが、難点は書き起こしても正解が分からない、という点です。

そんな時に役に立つのが書き起こしツールです。書き起こしツールはいくつか出ていますが、その中でもOtter.aiは比較的老舗だと思います。Otter.aiという名前はあまり聞いたことがないかもしれませんが、Zoom録画時の文字起こしには実はOtter.aiがバックエンドで使われています(後記:今は別のものを使っているかも知れません)。なので皆さん知らず知らずのうちにOtter.aiを使っていたということになるかも知れません。

Otter.aiは単独のアプリとしてiPhone/iPadやAndroidなどのデバイスでも動きます。例えば会議をOtter.aiで録音すると、その場でどんどん英語に書き起こしていってくれます。そのようにして書き起こされたテキストタップすると、そこから再生が始まるようになっていてとても便利です。英語のLive会議をOtter.aiで録音&書き起こしをしたり、YouTube上に録画が公開されているWebinarの文字起こしなど、英語を聞く多くの場面で役に立つでしょう(後記:最近はYouTube自体に字幕機能が付いているので、YouTubeとの組み合わせはあまり必要なくなっているかも知れません)。

以下は、バラクオバマ前大統領の大統領就任演説の様子をOtter.aiでライブで書き起こしをしている様子です(かっこいい演説なので、ちょっと長めにキャプチャしました)。

オバマ前大統領の就任演説をOtter.aiでライブ書き起こししたデモ

Otter.aiにも無料と有料のプランがあります。無料だとひと月に600分まで録音&書き起こすことができ、一回の録音は40分までです。 有料プランにするとこれらの制限がぐっと緩やかになり、ひと月に6,000分まで、一回の録音は4時間までできるようになります。 正直、無料プランでも十分ではないかと思います。私も無料プランしか使っていません。また、あの2020年後半に日本語に対応するみたいな話もあるので期待しましょう(後記:2022年12月時点ではまだ英語以外の言語はサポートされていません。また、各種上限なども変更になっていますのでご注意ください。)

リスニング:発音の確認

私が日々使っていて皆さんにご紹介したかったツールは以上なのですが、最後にもう一つ同僚の方から教えてもらったYouGlishというツールをご紹介したいと思います。これはYouTubeにあるコンテンツの中で使われている単語がどのように発音されているかを確認することができる、というツールです。

例えば、”encephalitis” という単語をどう発音するか分からなかったとしましょう。これをYouGlishで検索すると、この言葉が出てくる動画をYouTubeの中から探してきて、その箇所を再生してくれます。複数動画が見つかれば、それらを順に聞いていくこともできます。さらに検索時に対象の英語のアクセントを米国、英国、オーストラリア、カナダ に絞ることもできます(後記:現在は、アイルランド、スコットランド、ニュージーランドも指定することができます)。私はオーストラリア英語がとても苦手なので、この機能を使ってオーストラリア英語を練習するのにとても役に立ちそうです。

実は、前回紹介した「DeepL」ですが、多分「ディープ・エル」と読むのだろうと思いつつも、ひょっとして「ディープル」と読むのかも、と思い、このYouGlishで調べてみたのでした。その結果やはり「ディープ・エル」で良さそう、という結論になったのでした。

次回

今回はリスニングに役に立ちそうなツールを中心にお話をしました。ここまでが2020年7月にヴイエムウェア社内で話した「私、英語とこんな付き合い方をしています(ツール編)」の内容となります。しかし、それから日にちが経ち、色々と新しいサービスなども出てきたので、次回は2020年7月以降のアップデートをお届けしたいと思います。

Photo by Alex Litvin on Unsplash